陸AI百模大戰 專家:羣模亂舞

圖/新華社

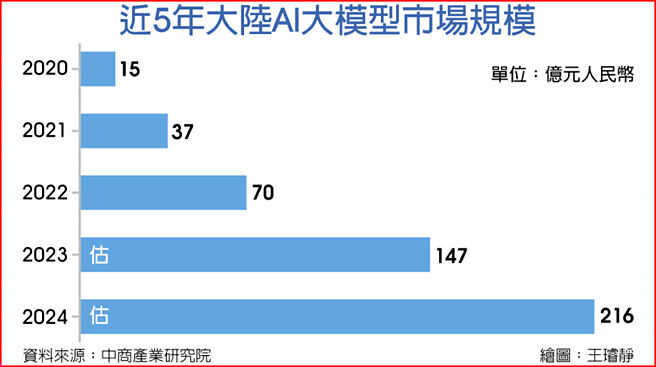

近5年大陸AI大模型市場規模

隨着AI聊天機器人ChatGPT爆紅,全球各大企業爭相研發自家AI大模型,光是在大陸市場,就有逾100款大模型問世,被形容有如「百模大戰」。大陸半導體業者近日表示,「百模大戰」更像是「羣模亂舞」,是在浪費電,實際上不需要這麼多個,並預估2028年大陸基礎大模型數量將少於10個,最好的狀況是5個。

近日在上海舉辦的2024世界人工智慧大會期間,大陸RISC-V產業聯盟理事長、陸股上市半導體業者芯原股份董事長戴偉民表示,按照目前的生成式AI技術路線,要想達到甚至是超越人腦的智慧,就需要持續擴大模型的參數規模,這也給運算力的要求帶來指數級增長。如果要達到超級AI,可能需要1,000萬張H100加速卡,耗電量相當於大陸一箇中等省份。這就會面臨很多問題,到那個時候全球可能只有少數國家的少數企業才能夠負擔的起。

稍早舉辦的第13屆芯原CEO論壇上,芯原股份針對大模型的未來提出五大預測:一、與無差異化的多模態大模型相比,以語言爲基礎的多模態大模型會成爲主流。二、2026年,內置AIGC(AI生成內容)的手機將成爲中高階手機的主流,是中高階手機換機的主要動能。三、2026年,全球雙目全綵擴增實境(AR)眼鏡出貨量將突破1,000萬臺。四、2028年,用於端側微調卡及推理卡的銷售額,將超過用於雲側的訓練卡。五、2028年,大陸基礎大模型的數量將少於10個。

華爲常務董事、華爲雲CEO張平安在世界人工智慧大會上表示,大陸的AI發展離不開算力基礎設施的創新,並且要敢於開放行業情境,讓AI在行業應用上領先。

至於華爲如何因應缺乏先進晶片的問題?張平安指出,華爲創新的方向是把端側的AI算力需求,透過光纖及無線網路釋放到雲上,透過端雲協同獲得無縫的AI算力。透過雲側的算力,讓端側既保持豐富的功能,又極大地降低功耗與對晶片的依賴。