IG同篇貼文底下 不同性別會看到不同的留言?小心AI正在強化你的無意識偏見

日前有網友發現,Instagram(IG)超級神功能又迴歸了,讓看訊息可以悄悄偷看。(示意圖/法新社)

原來IG貼文底下,不同性別看到的留言不一樣?這些AI潛在的無意識偏見,你有察覺到嗎?

IG同則貼文下,不同人會看到不同的留言?

在數位時代,人工智慧(AI)已深入我們生活的各個層面。然而,AI應用不當可能會加劇無意識偏見,特別是在性別議題上。

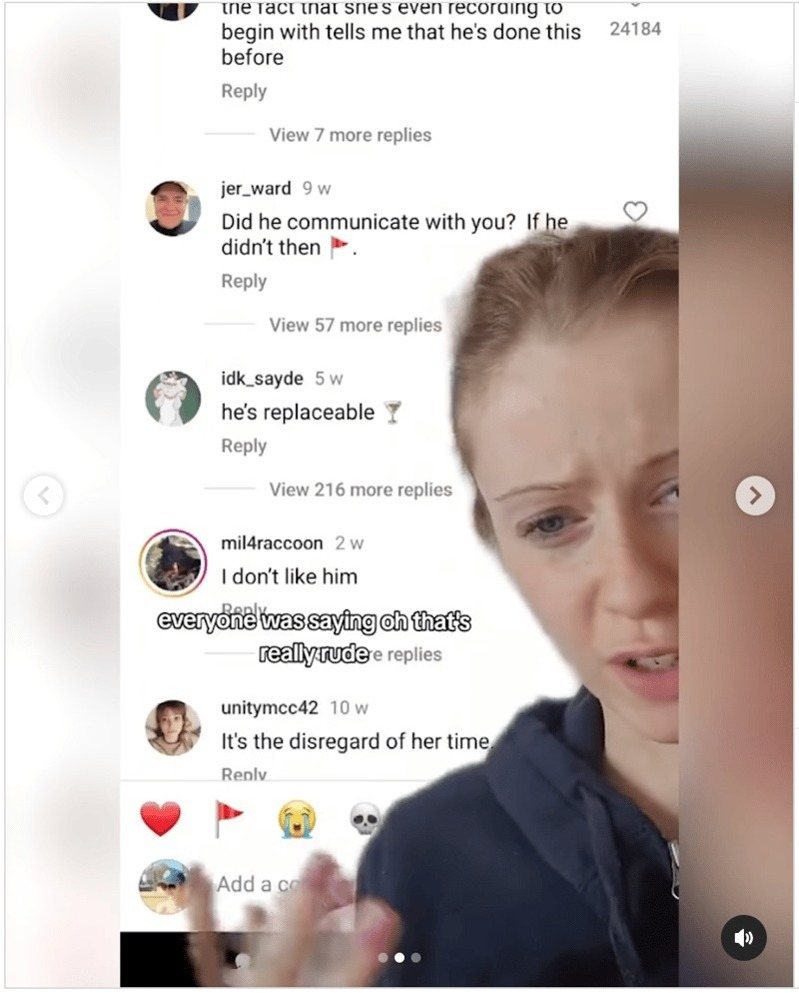

一個引人深思的例子來自社交媒體平臺Instagram,一位內容創作者thekingzletter分享了一個有趣的觀察:在一則關於「女生抱怨男友遲到」的影片下,男性和女性用戶看到的熱門評論完全不同。

女性用戶看到的評論多是支持影片中的女生,如:

圖/擷自內容創作者thekingzletter的IG帳號

男性用戶看到的評論則傾向支持男友,例如:

圖/擷自內容創作者thekingzletter的IG帳號

爲什麼會看到不一樣的留言?AI的演算法造成什麼現象?

該篇貼文下,有位機器學習研究者分享造成這個現象的原因爲協同過濾(collaborative filtering),目的是最大化用戶的螢幕使用時間。

AI演算法根據每位用戶的使用習慣,顯示最可能吸引他們繼續瀏覽的評論。在社交軟體環境中,協同過濾可能導致用戶只看到與自己觀點相似的評論。這種機制雖然提高了用戶參與度,卻也可能強化既有觀點,限制多元視角的接觸。

透過此案例的留言現象,我們也發現3點AI演算法會造成的現象如下:

還有哪些AI應用,有顯示出性別偏見的案例?

這個社交軟體的例子只是冰山一角。近年來,AI在各個領域的應用都顯示出性別偏見的問題。

一、圖像生成系統中的性別偏見

根據Nature的報導,AI圖像生成器(如Midjourney)在生成專業人員的圖像時,對性別存在偏見。例如,當被要求生成某些「專業」的人物圖像時,系統往往會生成男性形象,特別是在年齡較大的專業人員中,這強化了性別偏見。

二、醫療診斷系統中的性別偏見

根據IBM - United States的報導,醫療診斷系統在對不同種族和性別的病患進行診斷時準確性不同。例如,對於黑人的診斷準確性低於白人,這是因爲系統訓練數據中女性和少數族裔數據不足。

三、招聘中的性別偏見

根據IBM - United States及World Economic Forum的報導,許多應用追蹤系統(如亞馬遜的招聘系統)使用自然語言處理演算法來篩選簡歷,但這些演算法往往會根據某些特定的詞語(如“executed 執行”或“captured 捕捉”)進行偏見篩選,這些詞語更常出現在男性簡歷中,導致女性應徵者受到不公平對待。

四、虛擬助理中的性別偏見

根據IPI Global Observatory的描述,人工智慧工具女性化的趨勢模仿並強化了社會的結構等級和刻板印象,「男性」機器人被認爲更適合安全相關工作,而當日本在2015年推出第一家配備機器人接待員的飯店時,大多數機器人都是「女性」。

亞馬遜的Alexa、微軟的Cortana和蘋果的Siri等「家庭虛擬助理」都優先被賦予了女性聲音。

面對這些挑戰,我們如何有意識行動?

個人層面

1. 定期進行「算法清理」:定期檢查並調整社交軟體和搜索引擎的設置,如清理瀏覽歷史、重置推薦算法,或使用隱私瀏覽模式,以減少同溫層效應。

2. 參與DEI與無意識偏見相關培訓:主動參加或組織有關無意識偏見、共融領導力、文化敏感度的培訓課程。這些課程可以幫助我們認識到自己可能存在的盲點,並學習如何更好地實踐DEI原則。

組織層面

1. 建立多元共融的AI治理架構與組建多元化的AI開發團隊,確保不同背景的人才參與。

2. 制定明確的AI使用DEI指導原則,爲員工提無意識偏見培訓,提高對潛在偏見的認識。

3. 設立AI倫理委員會或審覈小組,實施持續的AI系統DEI評估,分析對不同羣體的影響,及時調整系統以確保公平性。

通過上訴行動策略,我們可以系統性地應對AI強化無意識偏見的挑戰,創造更公平、共融的環境,同時提高AI系統的可靠性和社會接受度。

延伸閱讀